Highlights der Entwicklerkonferenz NODES 2021: Neo4j Fabric, Neo4j 4.3, Neo4j Aura Free und mehr

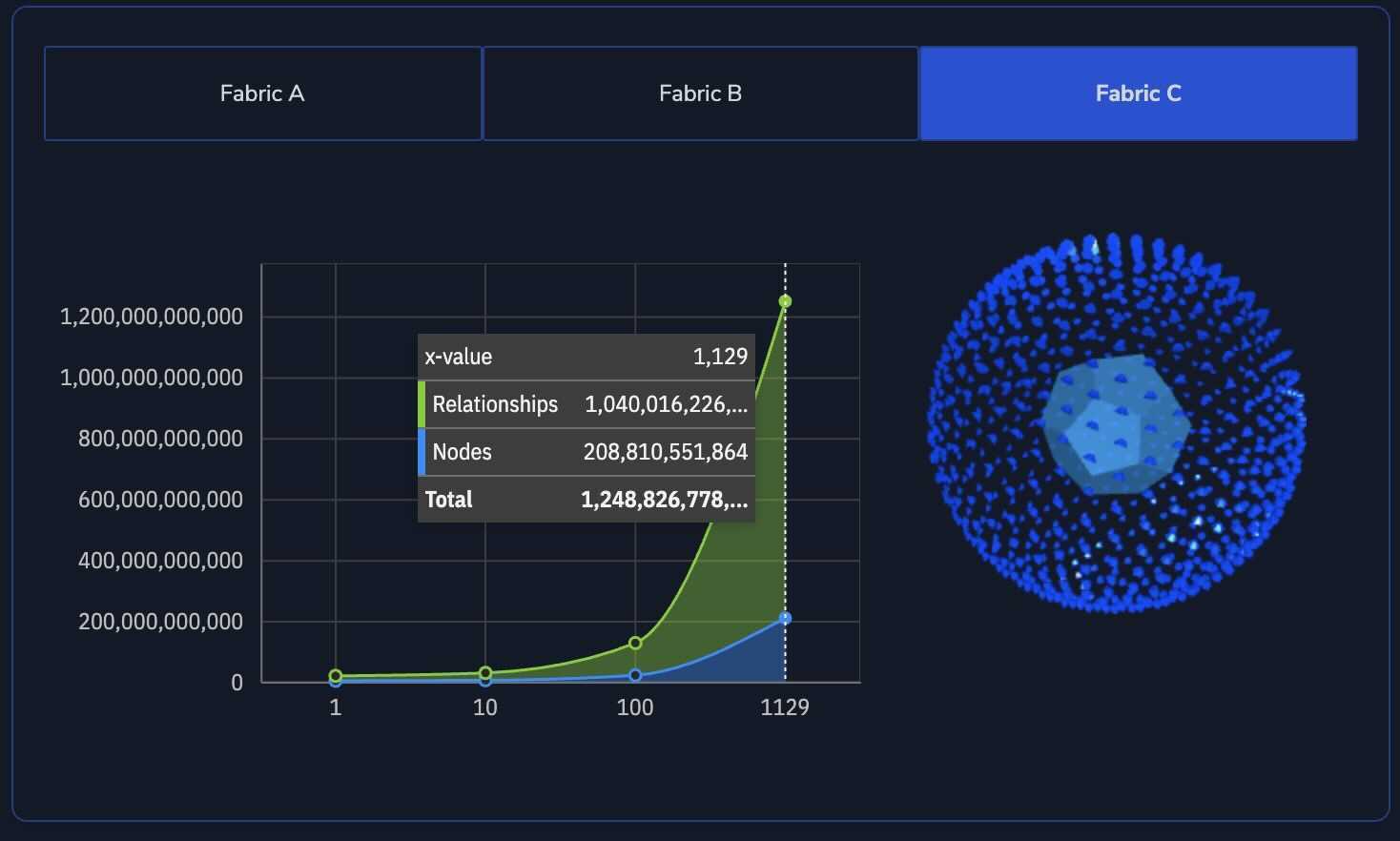

München, 22. Juni 2021 – Auf der Entwicklerkonferenz NODES 2021 stellte Neo4j ein für alle Mal die Skalierbarkeit seiner Graphdatenbank unter Beweis. Im Rahmen der Keynote von CEO Emil Eifrem führte das Neo4-Team eine Echtzeit-Abfrage in einem Graphen mit über 200 Milliarden Knoten und mehr als 1 Billion Beziehungen (Kanten) durch. Die Abfrage lief auf über tausend Rechnern.

Die enorme Skalierbarkeit wird deutlich, rückt man die Zahlen in einen greifbaren Kontext: So könnte ein Graph mit einer Billion Kanten die sozialen Beziehungen der gesamten Weltbevölkerung realitätsnah abbilden. Die Antwortzeiten betragen dabei nur wenige Millisekunden.

Abfragen dieses Ausmaßes werden angesichts Künstlicher Intelligenz (KI) und Machine Learning zunehmend realistischer. Den meisten Unternehmen fehlen jedoch die notwendige Plattform und Produktionsumgebung, um große Mengen vernetzter Daten effektiv speichern, managen und nutzen zu können. Graphdatenbanken gelten hier als die Technologie schlechthin, um die stetig wachsenden Daten-Anforderungen zu erfüllen.

Die Technologie hinter der Skalierbarkeit der Neo4j-Graphdatenbank heißt Neo4j Fabric. Fabric ermöglicht es, Datensätze zu teilen und unbegrenzt horizontal zu skalieren. Im Gegensatz zu anderen Anbietern müssen Anwender dabei keine Einbußen hinsichtlich Lese- und Schreibperformance in Kauf nehmen.

Weitere NODES 2021 Highlights

In seiner Key Note stellte Emil Eifrem, CEO und Mitbegründer von Neo4j, außerdem das Release Neo4j 4.3 vor und kündigte eine kostenlose Version der Cloud-Graphdatenbank an: Neo4j Aura Free. Die Graphdatenbank-as-a-Service soll zukünftig bis zu einer Anzahl von 50.000 Knoten and 175.000 Beziehungen kostenfrei zur Verfügung stehen. Zu den weiteren Highlights gehören neue Features im Visualisierungstool Neo4j Bloom und der Graph Data Science Library.

„Künstliche Intelligenz bzw. Machine Learning ist momentan das Top-Thema der Branche. Laut Gartner wird bei 50% aller Anfragen von Unternehmen zu KI auch automatisch die Frage nach dem Einsatz von Graphtechnologie gestellt. Das zeigt sehr deutlich, wohin die Reise in Sachen Graphen geht“, erklärt Eifrem. „Graphtechnologie ist heute längst kein Feature oder eine API mehr, sondern stellt eine eigene Kategorie an Datenbanken dar. Neo4j hat gemeinsam mit seiner Community diese Kategorie aufgebaut und nimmt darin die Führungsposition ein. Diesen Vorsprung wollen wir weiter ausbauen.“

Ein deutliches Zeichen dafür war in diesem Zusammenhang die Nachricht vom Abschluss der Serie F-Finanzierungsrunde mit 325 Millionen US-Dollar. Die Runde stellt die bislang größte Investition in eine Datenbanktechnologie dar und hebt den Marktwert von Neo4j auf über 2 Mrd. US-Dollar. Mit der Investition plant das Unternehmen, vor allem den Bereich Graph Data Science weiterzuentwickeln, das Cloud-Portfolio auszubauen und die Marktpräsenz sowie das Graph-Ökosystem zu stärken.

Insgesamt berichteten auf der NODES 2021 Entwickler und Data Architects in 50 Sessions über aktuelle Graph-Projekte und Lösungen. Dazu gehörten unter anderem Datenexperten von BASF, Fujitsu Research Labs oder Apiax. Für die virtuelle Konferenz meldeten sich mehr als 13.000 Graph-Enthusiasten aus aller Welt an.

Alle Vorträge können als Video auf der Neo4j Webseite angesehen werden. Details zur Skalierungs-Demo sind öffentlich auf Github verfügbar und können im Blog „Behind the Scenes of Creating the World“ auf der Neo4j Webseite nachgelesen werden.

Neo4j ist der führende Anbieter von Graphtechnologie. Die weltweit am häufigsten eingesetzte Graphdatenbank unterstützt Unternehmen wie Deutsches Zentrum für Diabetesforschung e.V., NASA, UBS und Daimler darin, Zusammenhänge zwischen Menschen, Prozessen, Standorten und Systemen aufzudecken und datengestützte Vorhersagen zu treffen. Der Fokus auf Datenbeziehungen ermöglicht es, smarte Anwendungen zu entwickeln und die Herausforderungen vernetzter Daten zu meistern – von Analytics und künstlicher Intelligenz über Betrugserkennung und Echtzeit-Empfehlungen bis hin zu Knowledge Graphen. Weitere Informationen unter Neo4j.com und @Neo4j.

Firmenkontakt

Neo4j

Sabine Listl

Prinzregentenstraße 89

81675 München

089 41 77 61 16

neo4j@lucyturpin.com

http://www.neo4j.com

Pressekontakt

Lucy Turpin Communications

Sabine Listl

Prinzregentenstraße 89

81675 München

089 41 77 61 16

neo4j@lucyturpin.com

http://www.lucyturpin.de

Bildquelle: Neo4j