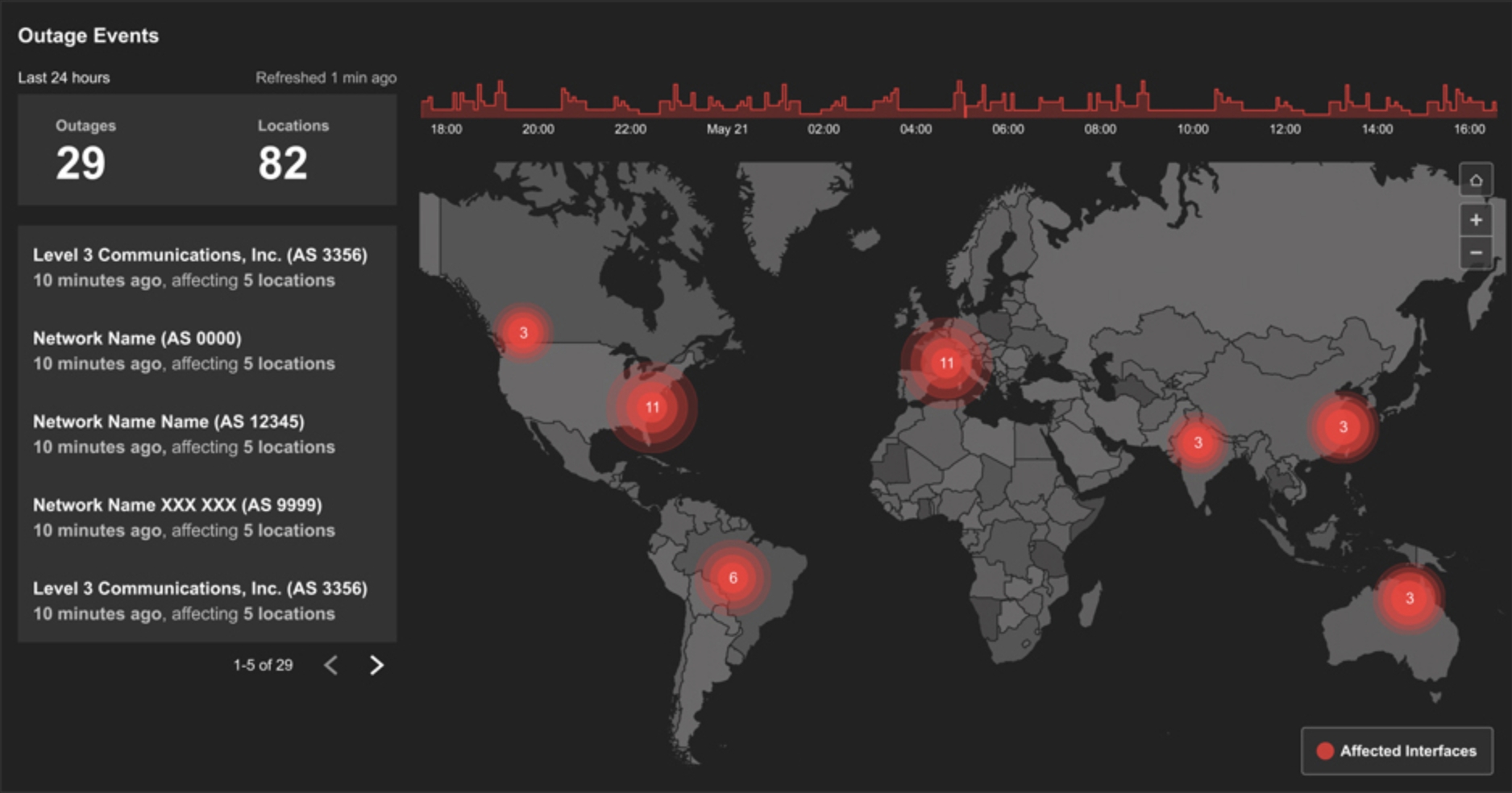

Seit sich die Abwehrmechanismen an einfache volumetrische DDoS-Angriffe angepasst haben und die meisten ISPs und Anbieter von Public Clouds in der Lage sind, einen grundlegenden Schutz gegen Floods auf der Netzwerkschicht zu bieten, verlegen sich Angreifer nach Angaben der Sicherheitsexperten von Radware zunehmend auf Angriffe auf die Anwendungen selbst.

DDoS-Angriffe auf der Anwendungsebene (Layer 7) stellen laut Radware eine einzigartige Herausforderung für die DDoS-Abwehr dar, da sie einen Einblick in das Anwendungsverhalten erfordern und es schwierig ist, allein anhand des Datenverkehrs auf der Netzwerkschicht zu erkennen, ob eine Anfrage legitim oder böswillig ist. Da zudem immer mehr Web-Verkehr mit SSL und HTTPS verschlüsselt wird, ist die DDoS-Abwehr häufig nicht in der Lage, den Inhalt des Pakets selbst einzusehen. Infolgedessen sind viele Arten von DDoS-Abwehrmaßnahmen nicht in der Lage, zwischen einer legitimen Spitze im Kundenverkehr (z. B. während einer Flash-Crowd oder einer Urlaubsspitze) und einem tatsächlichen Angriff zu unterscheiden.

Radware nennt insbesondere sieben Arten von DDoS-Angriffen auf Anwendungsebene, auf die man achten sollte:

HTTP/S Flood

HTTP Floods funktionieren, indem große Mengen von HTTP-Anfragen auf eine Webseite geleitet werden, um die Zielserver mit Anfragen zu überlasten. In dieser Hinsicht ähnelt diese Art von Angriff Floods auf Netzwerkebene, mit der Ausnahme, dass dieser Angriff auf der Anwendungsebene stattfindet und große Mengen von HTTP/S-GET- oder HTTP/S-POST-Anfragen verwendet.

Da der Großteil des Internet-Verkehrs heutzutage jedoch verschlüsselt ist, handelt es sich bei den meisten HTTP-Flooding-Angriffen heutzutage tatsächlich um HTTPS-Floods. Verschlüsselte Floods sind nicht nur wegen der hohen Menge an Server-Ressourcen, die zu ihrer Bewältigung benötigt werden, viel wirksamer, sondern fügen auch eine Ebene der Komplexität hinzu: Die DDoS-Abwehr kann in der Regel den Inhalt der HTTPS-Anforderungen nicht überprüfen, ohne den gesamten Datenverkehr vollständig zu entschlüsseln.

SSL Negotiation/Garbage Flood

Eine SSL Garbage Flood zielt speziell auf den SSL-Handshake-Mechanismus von Web-Anwendungen, um Server-Ressourcen zu überlasten. Der SSL/TLS-Handshake-Mechanismus ist ein hochgradig asymmetrischer Prozess, der bis zu 15 Mal mehr Rechenressourcen vom eingehenden Server als vom anfragenden Client erfordert. Das bedeutet, dass Angreifer mit nur wenigen Anfragen verheerende DDoS-Angriffe starten können.

Solche Angriffe funktionieren, indem sie eine große Anzahl von „Müll“-Anforderungen zur Initiierung von SSL/TLS-Verbindungen senden, um die Ressourcen zu überlasten und die Fähigkeit des Servers, neue Verbindungen anzunehmen, einschränken. Auch HTTPS Floods machen sich diesen Mechanismus zunutze, es gibt aber auch andere Varianten wie verschlüsselte SYN Floods oder SSL-Re-Negotiation, bei denen SSL-Handshakes kontinuierlich initiiert, abgebrochen und dann neu erstellt werden.

Low and Slow

Wie Flood-Attacken zielen Low- und Slow-Angriffe darauf ab, Zielserver durch Überlastung der Server-Ressourcen auszuschalten. Im Gegensatz zu Flood-Angriffen geschieht dies bei Low-and-Slow-Angriffen jedoch nicht durch das Versenden großer Datenmengen, sondern vielmehr durch den umgekehrten Ansatz, bei dem eine kleine Anzahl von Verbindungen gesendet wird, die jedoch so lange wie möglich offen bleiben, bis die Ressourcen des Zielservers erschöpft sind.

Durch diesen Ansatz können Low-and-Slow-Angriffe unter dem Radar der traditionellen DDoS-Verteidigung auf der Grundlage von Schwellenwerten fliegen, da sie keine großen Spitzen im Datenverkehr verursachen, die durch Ratenbeschränkungen begrenzt werden können.

Es gibt zahlreiche Varianten dieses Ansatzes, die gewöhnlich nach den Hacking-Tools benannt sind, die sie verwenden. Eine häufige Angriffsvariante ist Slowloris, das HTTP-Anfragen offen hält, indem es ständig unvollständige HTTP-Header sendet, die Anfrage aber nie abschließt. Eine andere bekannte Variante ist R.U.D.Y. („R U Dead Yet?“), die HTTP-POST-Verbindungen mit dem Server herstellt, aber das Senden von POST-Daten so lange wie möglich vermeidet und dann die Daten sehr langsam sendet, wodurch die Fähigkeit des Servers, neue Verbindungen anzunehmen, eingeschränkt wird.

HTTP/S Bombing

Eine „HTTP-Bombe“ verwendet die HTTP-POST-Methode, um große, komplexe POST-Anforderungen zu senden (normalerweise als XML-Datenstruktur skriptiert), die der Zielserver dann zu parsen versucht. Aufgrund der Größe und Komplexität der POST-Anforderung (d.h. der „Bombe“) wird der Server am Ende jedoch große Mengen an Rechenressourcen verbrauchen, die letztendlich erschöpft sind und den Server zum Absturz bringen. Dies kann ein besonders schwer zu verteidigender Angriff sein, da er eine hohe Anzahl von Serverressourcen mit einer begrenzten Anzahl von Verbindungen nutzen kann.

Outbound Pipe Saturation Attack

Im Gegensatz zu den meisten DDoS-Angriffen zielt dieser Angriffsvektor nicht auf die eingehende Traffic-Pipe des Servers, sondern vielmehr auf die Sättigung der ausgehenden Traffic-Verbindung.

Viele webbasierte Dienste ermöglichen das Herunterladen großer Dateien wie Software-Updates, Betriebssystem-Images, Datenbanken, Anwendungsdaten usw. Selbst moderne Webseiten können sehr groß sein, wenn sie große Grafiken und andere Objekte enthalten. Angriffe auf das Herunterladen großer Dateien zielen darauf ab, die Fähigkeit des Servers zur externen Kommunikation auszuschöpfen, indem die ausgehende Verbindung mit großen Mengen ausgehender Daten gesättigt wird.

Dies kann eine sehr effektive Art des asymmetrischen Angriffs sein, da die Anfrage nur wenige Bytes umfasst, während die Antwort Gigabytes groß sein kann. Darüber hinaus können Angriffe auf die Sättigung der ausgehenden Pipe sehr schwer zu erkennen und abzuschwächen sein, da die meisten DDoS-Abwehrmaßnahmen nur auf den eingehenden, nicht aber auf den ausgehenden Datenverkehr ausgerichtet sind.

Bruteforce-Angriff

Obwohl nicht ausdrücklich als solche bezeichnet, tragen viele Arten von Angriffen auf Webanwendungen auch die Merkmale einer DDoS Flood. Dies liegt daran, dass Bruteforce-Angriffe auf Anwendungen häufig mit hohen Rate arbeiten und große Mengen an Fehlermeldungen auf Anwendungsebene erzeugen, die vom Server verarbeitet und bearbeitet werden müssen.

Beispiele für solche Bruteforce-Versuche sind das Scannen von Servern, das Knacken von Passwörtern, das Ausfüllen von Zugangsdaten und vieles mehr. Die Herausforderung beim Umgang mit solchen Arten von Bruteforce-Angriffen besteht darin, dass es ohne vorherige Verarbeitung der Anfrage normalerweise sehr schwierig ist, zu wissen, welche Anfrage legitim ist und welche nicht.

Denial of Inventory

Diese Art des Angriffs auf der Anwendungsebene ist an sich kein DDoS-Angriff, aber er erreicht dieselben Ziele, indem er die Fähigkeit des Unternehmens, seine Kunden zu bedienen, zunichte macht. Denial-of-Inventory-Angriffe verwenden automatisierte Bots, um in die Anwendungen des Unternehmens einzudringen und Kaufanfragen zu initiieren, ohne den Kauf tatsächlich abzuschließen. Infolgedessen wird der Bestand, der sich auf die Kaufanfrage bezieht – wie z.B. Flugtickets, Veranstaltungstickets, Lagerbestand usw. – vorübergehend gesperrt und ist für tatsächliche Kunden, die denselben Bestand kaufen möchten, nicht verfügbar.

Obwohl diese Art von Angriff nicht auf die Traffic-Pipe oder die Server-Ressourcen selbst abzielt, erzielt er dasselbe Ergebnis, indem er legitimen Kunden den Service verweigert. Auch dies ist eine besonders schwer abzuschwächende Form des Angriffs, da es schwierig ist, einen tatsächlich zahlenden Kunden von einem Bot zu unterscheiden.

„Angesichts der Agilität, die finanziell gut ausgestattete Hacker heute erreichen können, reichen menschliche Diagnose und Mitigation nach Angaben nicht mehr aus“, so Michael Tullius, Managing Director DACH bei Radware. „Sie erfordert Anti-DDoS-Lösungen, die maschinelles Lernen mit negativen und positiven Sicherheitsmodellen kombinieren.“ Herkömmliche DDoS-Lösungen verwenden die Limitierung von Datenraten und manuelle Signaturerstellung, was zu einer erheblichen Anzahl von False Positives führt und neue Angriffsvektoren deutlich zu spät identifiziert.

Radware® (NASDAQ: RDWR) ist ein weltweit führender Lösungsanbieter im Bereich Anwendungsbereitstellung und Cybersicherheit für virtuelle, cloudbasierte und softwaredefinierte Rechenzentren. Das preisgekrönte Portfolio des Unternehmens sichert die unternehmensweite IT-Infrastruktur sowie kritische Anwendungen und stellt deren Verfügbarkeit sicher. Mehr als 12.500 Enterprise- und Carrier-Kunden weltweit profitieren von Radware-Lösungen zur schnellen Anpassung an Marktentwicklungen, Aufrechterhaltung der Business Continuity und Maximierung der Produktivität bei geringen Kosten.

Weitere Informationen finden Sie unter www.radware.com

Firmenkontakt

Radware GmbH

Michael Tullius

Robert-Bosch-Str. 11a

63225 Tel Aviv / Frankfurt am Main

+49-6103-70657-0

info_de@radware.com

https://www.radware.com

Pressekontakt

Prolog Communications GmbH

Achim Heinze

Sendlinger Str. 24

80331 München

089 800 77-0

radware@prolog-pr.com

https://www.prolog-pr.com/radware

Bildquelle: Radware GmbH

Die Nachfrage nach virtuellen Servern bzw. skalierbarem Cloud-Hosting in Deutschland bleibt ungebrochen hoch. Der deutsche Business Hosting Anbieter ScaleUp Technologies hat seine Cloud-Infrastruktur in Hamburg nun weiter ausgebaut. Die neue Public Cloud aus Deutschland ist eine Erweiterung der drei vorhandenen Cloud-Standorte von ScaleUp (in Berlin, Hamburg und Düsseldorf) und die bisher größte Cloud des deutschen Business Hosting und Server-Colocation Unternehmens. Erste Kunden haben die neue virtuelle IT-Infrastruktur bereits bezogen, die im Juni 2022 in Hamburg produktiv ging.

Die Nachfrage nach virtuellen Servern bzw. skalierbarem Cloud-Hosting in Deutschland bleibt ungebrochen hoch. Der deutsche Business Hosting Anbieter ScaleUp Technologies hat seine Cloud-Infrastruktur in Hamburg nun weiter ausgebaut. Die neue Public Cloud aus Deutschland ist eine Erweiterung der drei vorhandenen Cloud-Standorte von ScaleUp (in Berlin, Hamburg und Düsseldorf) und die bisher größte Cloud des deutschen Business Hosting und Server-Colocation Unternehmens. Erste Kunden haben die neue virtuelle IT-Infrastruktur bereits bezogen, die im Juni 2022 in Hamburg produktiv ging.